環境

- OS: CentOS Linux release 7.4.1708 (Core)

- CUDA: 9.0

- GPU: Nvidia GTX 1070

GPU を認識しているか確認

CentOS 側が GPU を認識しているかどうかは

- lspci

などで分かります。出力の中にGPUの名前があればOK。

CUDA のインストール

ドライバは入っているものとします。というか特殊なGPUで以外 xorg-x11-drv-nvidia-libs などを入れると動いたり。

この辺は試行錯誤したので minimal な手順が残ってなかったり……。

ということでドライバ周りは飛ばして、CUDA のインストールをします。

この辺は試行錯誤したので minimal な手順が残ってなかったり……。

ということでドライバ周りは飛ばして、CUDA のインストールをします。

まずは NVIDIA の公式サイトから、CUDA をダウンロードします。ここのページでOSやバージョンを選んでいく。

今回は Linux + x86_64 + RHEL + 7 + rpm(network) を使います。

後は出てきたコマンドに従うだけ。

- wget http://developer.download.nvidia.com/compute/cuda/repos/rhel7/x86_64/cuda-repo-rhel7-9.0.176-1.x86_64.rpm

- sudo rpm -i cuda-repo-rhel7-9.0.176-1.x86_64.rpm

- sudo yum clean all

- sudo yum install -y cuda

rpm(network) だと、インストールの際に依存パッケージも入るので、これでおしまい。

1G とか降ってくるので、コマンドは短かくても結構時間がかかったりします。

なお、記事を書いている時点(2017/12/10) では 7.5, 8.0 も入れることができます。

具体的には

1G とか降ってくるので、コマンドは短かくても結構時間がかかったりします。

なお、記事を書いている時点(2017/12/10) では 7.5, 8.0 も入れることができます。

具体的には

- $ sudo yum install -y cuda-8-0

のようにバージョンを指定してあげるとOK。

バージョンを省略すると最新の CUDA が入ります。

/usr/local/cuda 以下にいろいろと入るので、PATH などを設定します。具体的には

などですね。

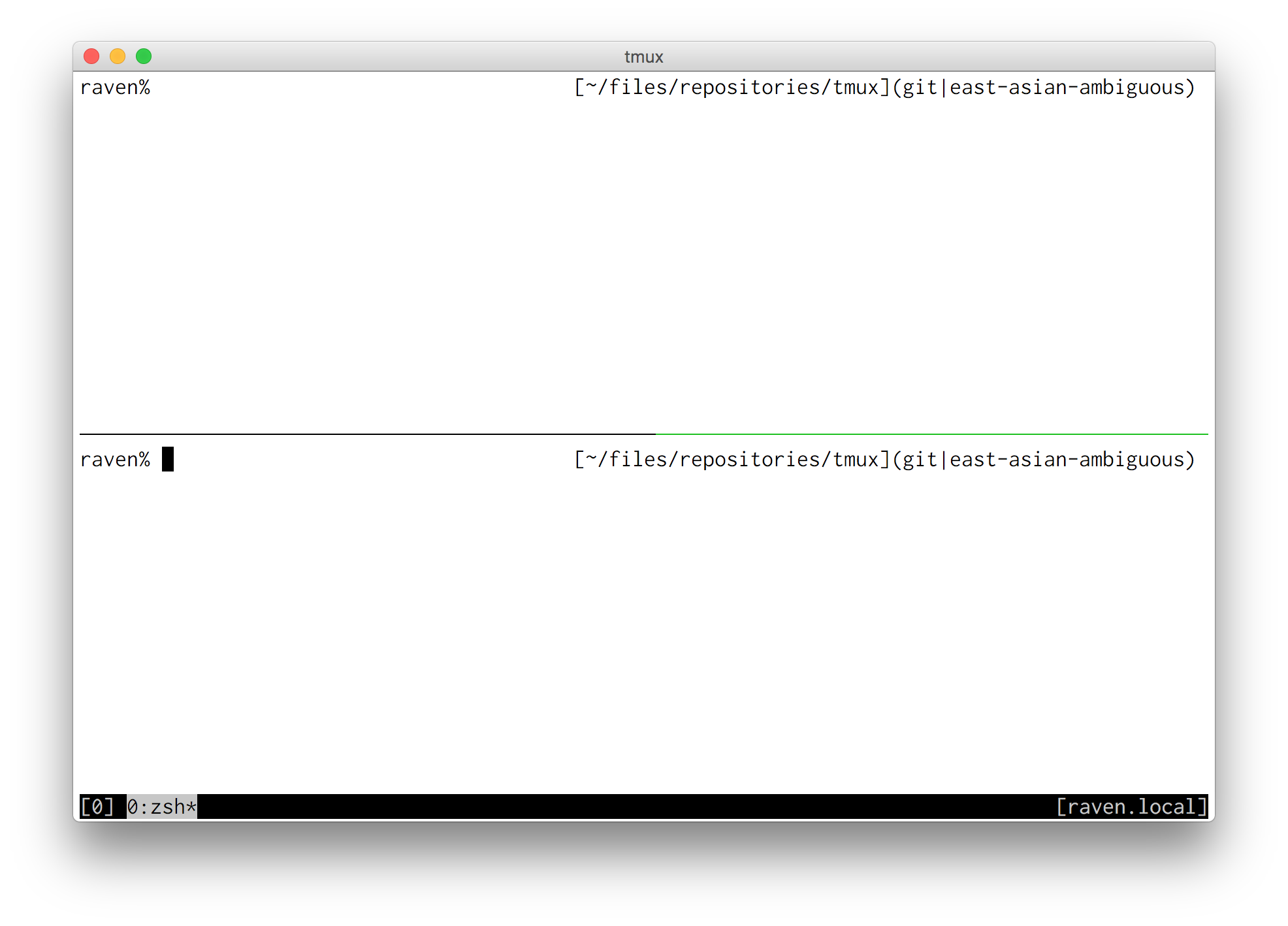

GPU が動いてるか確認

- $ nvidia-smi

あたりでGPUの状態が分かります。結果は

のように出力されます。この場合GPUの使用率は100%なので、かなり頑張っていますね。